Tổng: đ0

HBM4: Bước ngoặt bộ nhớ mở đường cho GPU AI 3

Trong bối cảnh SK hynix và Micron chuẩn bị tăng tốc sản xuất HBM4 từ cuối 2025, thị trường bán dẫn bước vào một giai đoạn mới đầy cạnh tranh. Đây là thời điểm thích hợp để nhìn lại HBM, bộ nhớ băng thông cao (High Bandwidth Memory) đang trở thành nền tảng không thể thiếu trong kỷ nguyên AI.

HBM4: vì sao nó quan trọng và khác biệt căn bản

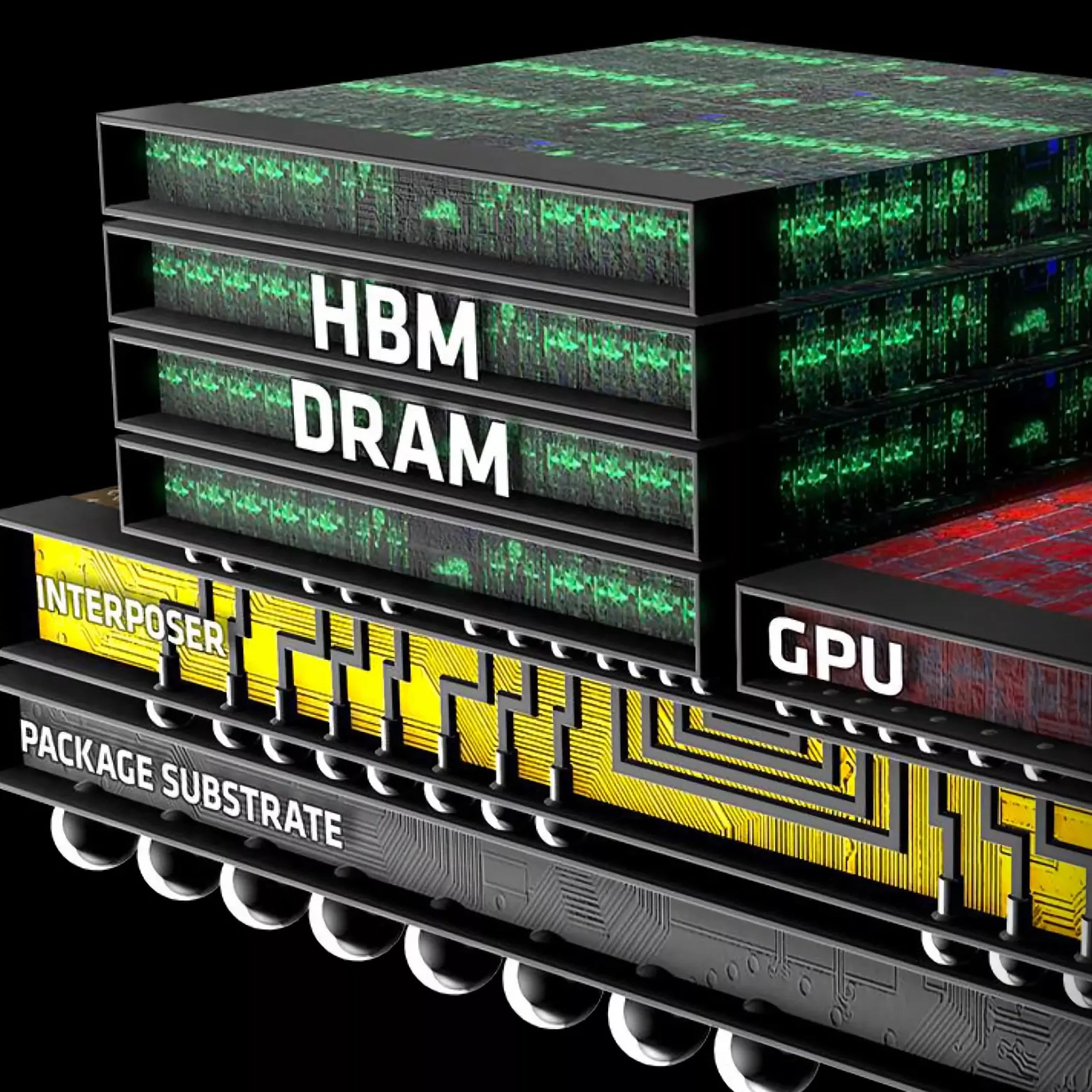

Khi nói về hiệu năng cho AI, vấn đề không chỉ là “GPU càng mạnh càng tốt” mà là “GPU có dữ liệu nhanh đủ để xử lý hay không”. Trong hai thập kỷ qua, sức mạnh tính toán của GPU tăng cực mạnh, nhưng băng thông bộ nhớ (DRAM) chỉ tăng rất khiêm tốn so với nhu cầu mới — dẫn tới cái gọi là memory wall. HBM (High Bandwidth Memory) được tạo ra để xử lý đúng nút thắt này: thay vì nối nhiều thanh DRAM rời rạc quanh GPU, HBM xếp chồng các die DRAM lên một logic die và kết nối qua hàng nghìn kênh song song. Kết quả là băng thông tăng theo cấp HBM4 có thể đạt mức terabyte/giây, trong khi tiêu hao điện năng vẫn thấp hơn nhiều so với giải pháp truyền thống như DDR4.

Kỹ thuật phía sau: logic die, I/O và tản nhiệt

Điểm then chốt của HBM4 không chỉ nằm ở số lớp DRAM mà còn ở logic die ở dưới cùng. Logic die phải quản lý hàng nghìn chân I/O (HBM4 tăng từ ~1.024 lên ~2.048 I/O), với khoảng cách cực nhỏ giữa các kết nối (chỉ vài micromet). Điều này đặt ra yêu cầu vô cùng khắt khe về độ chính xác gia công, về tản nhiệt và về chất liệu interposer nếu không xử lý tốt, thiết bị dễ gặp lỗi hoặc nhanh xuống hiệu năng do nhiệt. Vì vậy, HBM không đơn giản là “nhiều chip ghép lại”, mà là một hệ thống tích hợp cơ - điện - nhiệt ở cấp độ vi mô.

Tại sao sản xuất lại đắt đỏ và rủi ro về năng suất

Sự phức tạp kỹ thuật kéo theo chi phí: thiết kế die lớn hơn để chứa I/O nhiều hơn, quy trình xếp chồng nhiều lớp làm tăng tỉ lệ lỗi (TSV yield), và các bước gia công đặc thù (underfill, reflow, compression, hybrid bonding) đều cần công nghệ cao và tỉ lệ thất thoát trong sản xuất cao hơn DRAM thông thường. Theo các ước tính thị trường mà bạn đã dùng làm tham chiếu, HBM3e đã có premium ~20% so với bộ nhớ tiêu chuẩn; HBM4 được dự báo sẽ đắt hơn nữa (khoảng +30% so với HBM3e) vì số kênh I/O tăng, base die phức tạp hơn và yêu cầu kỹ thuật cao hơn.

Các giải pháp kỹ thuật nhà sản xuất đang dùng

Các nhà sản xuất đang chạy đua cả về phương pháp ghép và vật liệu để cải thiện yield và tản nhiệt. Ví dụ, một bên dùng MR-MUF (kết hợp reflow và underfill trong một bước) để rút ngắn quy trình và tăng độ bền; bên khác dùng TC-NCF (ép nhiệt với phim không dẫn) nhằm bảo vệ tiếp điểm. Xu hướng kế tiếp là hybrid bonding, kết nối trực tiếp mà không cần bump giúp stacks mỏng hơn, giảm tổn hao tín hiệu và mở đường cho nhiều lớp hơn nữa, nhưng đổi lại yêu cầu công nghệ chính xác hơn và năng lực foundry cao cấp.

Vai trò của foundry và cấu trúc thị trường

Vì các nền tảng logic die cần công nghệ sản xuất quy trình vi mô, các foundry hàng đầu (ví dụ TSMC) trở thành đối tác chiến lược, không chỉ gia công mà còn cùng phát triển quy trình cho HBM4/4E. Điều này làm thay đổi cấu trúc chuỗi cung ứng: nhà sản xuất DRAM cần hợp tác sâu hơn với foundry, và khả năng tiếp cận node sản xuất cao cấp trở thành lợi thế cạnh tranh lớn. Vì thế, HBM vẫn là “sân chơi” của số ít công ty có thể đầu tư quy trình, máy móc và tỉ lệ lỗi chấp nhận được.

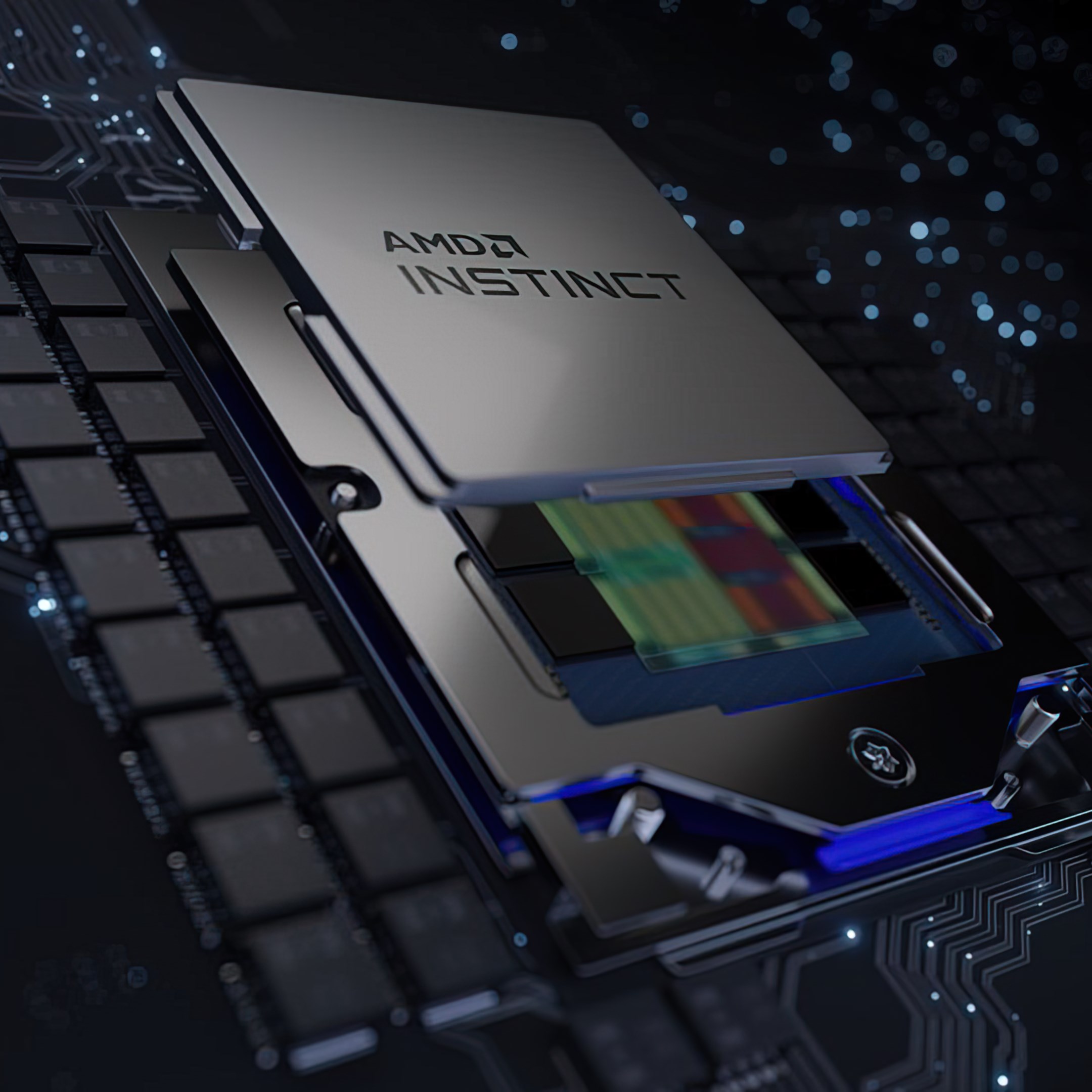

Dù nhiều tên tuổi tham gia, thị trường HBM mang tính tập trung cao. Theo các dự báo thị trường, SK hynix chiếm phần lớn giao hàng HBM (dẫn đầu), nhưng Samsung và Micron cũng chiếm vị trí quan trọng, mỗi hãng dự kiến nắm khoảng 20% thị phần. Ở góc độ nhu cầu cuối, NVIDIA và AMD là những “người đặt hàng lớn” vì GPU thế hệ mới của họ (ví dụ Rubin và MI400) được kỳ vọng tích hợp HBM4, kéo theo nhu cầu lớn và yêu cầu chứng nhận khắt khe.

Hệ quả thị trường và tác động chi phí cho doanh nghiệp

Việc HBM4 đắt hơn dẫn tới nhiều hệ quả: giá hệ thống server GPU cho workload AI có thể tăng, chi phí huấn luyện/triển khai mô hình tăng, và rủi ro thiếu hụt trong ngắn hạn cao khi nguồn cung tập trung. Các doanh nghiệp Cloud, AI startup, và trung tâm dữ liệu cần cân nhắc tổng chi phí sở hữu (TCO), vì HBM mang lại hiệu năng nhưng đổi lại chi phí phần cứng tăng và có thể cần thiết kế hệ thống, tản nhiệt, và phần mềm tối ưu lại.

Thay vì chạy theo “mua mọi thứ ngay”, các đơn vị vận hành hạ tầng nên cân nhắc ba hướng chính: một là theo dõi sát nguồn cung và đặt hàng sớm (pre-purchase) cho các SKU quan trọng để tránh thiếu hụt; hai là điều chỉnh kiến trúc hệ thống (kết hợp HBM cho các nút cần băng thông cực lớn và DDR/DDR5 cho các khối khác) để cân bằng hiệu năng/chi phí; ba là tối ưu phần mềm tổ chức dữ liệu, tăng locality, giảm phụ thuộc băng thông nếu có thể vì phần mềm tối ưu có thể giảm lượng HBM cần thiết cho một workload nhất định. Ngoài ra, hãy theo dõi chính sách giá của các nhà cung cấp lớn như Samsung, vì họ có thể điều chỉnh chiến lược sản xuất/giá để chiếm lợi thế thị phần.

Triển vọng: giữa chi phí và nhu cầu không thể đảo ngược

HBM4 là một bước tiến kỹ thuật bắt buộc cho nhiều workload AI hiện đại, nó giải quyết nút thắt băng thông nhưng đi kèm chi phí và rủi ro chuỗi cung ứng. Trong ngắn hạn, sự tập trung nguồn cung và premium giá sẽ gây áp lực lên chi phí triển khai AI, nhưng về trung - dài hạn, việc mở rộng sản xuất, cải tiến công nghệ bonding và sự tham gia sâu hơn của foundry có thể làm giảm giá xuống mức khả dụng hơn. Với vị thế hiện tại, Samsung là một trong những người chơi quan trọng cần theo dõi cả về động thái đầu tư công suất lẫn chiến lược giá vì những quyết định của họ sẽ ảnh hưởng đáng kể đến nguồn cung cho thị trường toàn cầu.

-87172aa372853.png)

-95b96d7461e13.jpg)

.png)

.png)

good

Awesome

Nice